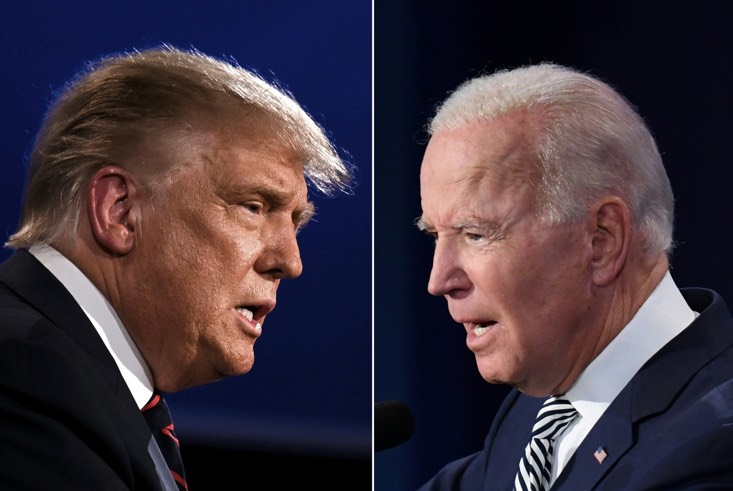

«تابناک با تو» - انتخابات هر کشوری، داستانی جداست. متغیرهای زیادی در آن دخالت میکنند. وعدههای غیرعملی توسط همه داده میشوند و طبق معمول قشر خاکستری که تصمیم میگیرند در لحظه آخر به چه کسی رای بدهند یا اصلا شرکت کنند یا نه، بسیار تاثیرگذار هستند. به همین خاطر هر خبر سطحیای در شبکههای اجتماعی میتواند تاثیر زیادی روی درصدها بگذارد. به ویژه با توجه به رای الکتورال در آمریکا، این موضوع اهمیت بیشتری پیدا میکند.

«تابناک با تو» - انتخابات هر کشوری، داستانی جداست. متغیرهای زیادی در آن دخالت میکنند. وعدههای غیرعملی توسط همه داده میشوند و طبق معمول قشر خاکستری که تصمیم میگیرند در لحظه آخر به چه کسی رای بدهند یا اصلا شرکت کنند یا نه، بسیار تاثیرگذار هستند. به همین خاطر هر خبر سطحیای در شبکههای اجتماعی میتواند تاثیر زیادی روی درصدها بگذارد. به ویژه با توجه به رای الکتورال در آمریکا، این موضوع اهمیت بیشتری پیدا میکند.

در ۲۷ فوریه، در آستانه انتخابات شهردار شیکاگو، یک حساب توییتری که خود را Chicago Lakefront News مینامد، تصویری از نامزد این سمت، پل والاس، مدیر سابق بودجه شهر و رئیس منطقه مدرسه که در یک رقابت تنگاتنگ چهارجانبه برای کسب رتبه برتر شهر بود، منتشر کرد. این کار، همراه با صدا بود.

به نظر میرسید او در این ویدئو تیراندازیهای پلیس را کم اهمیت جلوه میدهد و میگوید که «در زمان من» یک پلیس میتوانست ۱۸ غیرنظامی را در دوران حرفهای خود بکشد و برای کسی مهم نبود. ما باید از کاهش بودجه پلیس جلوگیری کنیم و شروع به بازپرداخت آنها کنیم.

بعد معلوم شد که والاس هیچ یک از این چیزها را نگفت. این صدا جعلی بود و احتمالاً با نرم افزار هوش مصنوعی به راحتی قابل شبیه سازی بود. حساب کاربری Chicago Lakefront News، که درست چند روز قبل از ارسال ویدیو ایجاد شده بود، به سرعت پست را حذف کرد – اما پیش از آن هزاران نفر توئیت را دیدند و به طور گسترده بازنشر شد، برخی ظاهراً فریب خوردند و این صدا را اصل پنداشتند.

اگرچه والاس در نهایت در دور دوم انتخابات در ۴ آوریل به رقیب براندون جانسون شکست خورد و به نظر نمی رسد که این صدا تأثیر قابل توجهی بر نتیجه رقابت شهرداری داشته باشد. با این حال، شبیهسازی صدای والاس پیشنمایش ترسناکی از اطلاعات نادرستی است که کارشناسان میگویند به لطف پیشرفتهای سریع در A.I، باید انتظار داشته باشیم که در انتخابات ریاستجمهوری ۲۰۲۴ ایالات متحده با آن روبرو شویم.

“A.I های مولد” و ChatGPT، تنها نمونه ای از این فناوریها است. شرکتی به نام ElevenLabs نرمافزاری منتشر کرده است که میتواند صداهای یک شخص را تنها با آنالیز چند ثانیه نمونه صدا شبیهسازی کند.

اکنون هر کسی میتواند با استفاده از نرمافزارهایی مانند OpenAI’s DALL-E 2، Stable Diffusion یا Midjourney، تصاویر واقعگرایی را تولید کند.

استارتآپ نیویورکی Runway نرمافزاری ایجاد کرده است که کلیپهایی به طول چند ثانیه تولید میکند و یک کلاهبردار ماهر در تکنیکهای دیپفیک میتواند ویدیوهای جعلی را بهقدری خوب بسازد که بسیاری از مردم را فریب دهد.

مردم البته از قبل هم میتوانستند اطلاعات نادرست بنویسند و توزیع کنند (همانطور که در انتخابات گذشته در رسانههای اجتماعی دیدهایم)، اما حالا توانایی انجام این کار با حجم و سرعت بیسابقهای میتواند صورت بگیرد.

از سوی دیگر این ابزارها بهویژه برای یک دولت-ملت مفید مانند روسیه، که در آن هدف تبلیغات، اقناع نیست بلکه باراندن انبوهی از دروغها و نیمهحقیقتها است، مغتنم است. این طوری سردرگمی و از بین بردن اعتماد ایجاد میشود و باعث شود مردم بیشتر به اطلاعاتی که توسط ارتباطات اجتماعی به اشتراک گذاشته شده است باور کنند تا حرف کارشناسان.

همه مطمئن نیستند که وضعیت به همان اندازه وخیم است و تصور میکنند که سال ۲۰۲۴ به طور قابل توجهی متفاوت از سال ۲۰۲۰ یا ۲۰۱۶ نیست.

برخی هم فکر میکنند که فناوری دیپفیک ویدیو هنوز به اندازهای خوب نیست که بتواند نقش مهمی در سال ۲۰۲۴ ایفا کند (اگرچه ممکن است در سال ۲۰۲۸ وضعیت تغییر کند).

اما شبیه سازی صدا از همین الان نگران کننده است و ممکن است قطعه صوتی تولید و منتتشر شود و ادعا شود که یک نامزد در یک جلسه خصوصی آنها را بر زبان رانده. البته این نامزد ممکن است این حرفها را کتمان کند، اما در میانه انتخابات این دیگر خیلی دیر است.

ساندرا واچر، استاد فناوری و مقررات در مؤسسه اینترنت آکسفورد، میگوید: مطالعات به نتایج متناقضی در مورد اینکه آیا روایتهای نادرست کسی را متقاعد میکنند یا فقط باورهای موجود را تقویت میکنند، رسیدهاند. اما در یک انتخابات نزدیک، حتی چنین تأثیرات حاشیهای می تواند تعیین کننده باشد.»

در مواجهه با تهدید اخبار جعلی تولید شده توسط هوش مصنوعی، برخی معتقدند خود A.I. ممکن است خود بهترین دفاع را ارائه دهد. در اسپانیا، شرکتی به نام Newtral که متخصص در بررسی ادعاهای سیاستمداران است، در حال آزمایش با مدلهای زبانی بزرگ شبیه به آنهایی است که در ChatGPT استفاده میشود.

روبن میگوئز پرز، مدیر ارشد فناوری نیوترال، میگوید در حالی که این مدلها واقعاً نمیتوانند حقایق را تأیید کنند، میتوانند انسانها را در رد کردن دروغها تواناتر کنند. این فناوری «تطابق ادعا». میگوئز پرز میگویدبا جفت کردن مدلهای زبان بزرگ با سایر نرمافزارهای یادگیری ماشینی، میتوان احتمال اطلاعات نادرست بودن چیزی را بر اساس احساسات بیان شده در محتوا ارزیابی کند. میگوئز پرز میگوید با استفاده از این روشها، زمان لازم برای شناسایی اظهارات ارزش بررسی واقعیت را بین ۷۰ تا ۸۰ درصد کاهش مییابد.

پلتفرمهای بزرگ رسانههای اجتماعی، مانند متا و یوتیوب گوگل، روی A.I کار می کنند. در آستانه انتخابات ریاستجمهوری ۲۰۲۰ ایالات متحده، شرکت مادر فیسبوک متا میگوید که هشدارهایی را در مورد بیش از ۱۸۰ میلیون محتوایی که توسط بررسیکنندگان حقایق شخص ثالث حذف شدهاند، نمایش داده است.

با این حال، بسیاری از اطلاعات نادرست از طریق لغزش در تشخیص و میمها، منتقل میشوند. متا میگوید که سیستمهایش از زمان انتخابات ۲۰۲۰ بهتر شدهاند، ولی افرادی که روایتهای نادرست را ترویج میکنند به طور مداوم تغییرات جدیدی را طراحی میکنند که A.I. قبلا آنها را تجربه نکرده است.

مارکوس میگوید آنچه که شاید لازم باشد اعمال شود تفاوت، مقررات است: کسانی که مدلهای زبان بزرگ را ایجاد میکنند باید «واترمارکهای دیجیتال» ایجاد کنند که شناسایی محتوای ایجاد شده توسط A.I را برای الگوریتمهای دیگر آسانتر میکند.

OpenAI، خالق ChatGPT، درباره این نوع واترمارک صحبت کرده است، اما هنوز آن را اجرا نکرده است و نرم افزار تشخیص محتوای A.I. رایگان را منتشر کرده، اما فقط در حدود یک سوم موارد کار میکند. مارکوس همچنین میگوید کنگره باید تولید و توزیع اطلاعات نادرست را مقیاس بزرگ غیرقانونی اعلام کند. البته طرفداران متمم اول قانون اساسی ممکن است مخالفت کنند، اما مسلما تدوینکنندگان قانون اساسی هرگز فناوریای را تصور نمیکردند که بتواند با فشار دادن یک دکمه مجموعهای از دروغهای متقاعدکننده را تولید کند.

اواخر قرن هجدهم، زمانی که ایالات متحده تأسیس شد، دوران طلایی اطلاعات نادرست نیز بود، در آن زمان با شب نامهها و روزنامههای حزبی که داستانهای سخیف درباره سیاستمداران و احزاب مخالف مینوشتند این کار انجام میشود. واچتر آکسفورد خاطرنشان می کند که دموکراسی در آن زمان زنده ماند. پس شاید این بار هم همینطور باشد. اما جو مسلما متفاوت است.

منبع: یک پزشک